2000: El año que no se acabó el mundo

El temor a un fallo generalizado de los sistemas informáticos hizo temer una catástrofe planetaria.

(Foto: E&J)

2000: El año que no se acabó el mundo

El temor a un fallo generalizado de los sistemas informáticos hizo temer una catástrofe planetaria.

(Foto: E&J)

El apocalipsis ha obsesionado a la humanidad a lo largo de toda su existencia. El fin del mundo está muy presente en muchas religiones y creencias, que desarrollan todo tipo teorías sobre cómo se va a acabar la vida en la Tierra. Generalmente, estas teorías dan de sí para unos meses de reportajes de prensa y documentales más o menos sesudos o, si acaso, para alguna superproducción de catástrofes en las que salta por los aires la Casa Blanca o el Empire State.

Sin embargo, ha habido un momento en la historia reciente en el que, si no el fin del mundo, sí se ha podido producir un desastre considerable a nivel mundial. Nos referimos a lo que se ha dado en llamar el Efecto 2000 o, como se le ha conocido en todo el mundo Y2K bug por el numerónimo Y2K (en el que Y=year o año, 2=dos y K=kilo o 1.000).

Ese bug o error del milenio se basaba en la programación de las fechas en los sistemas informáticos. Se utilizaban dos dígitos al indicar el día, el mes y el año, y en este último apartado, los sistemas siempre asumían que el año pertenecía al siglo XX. Si se incluía allí «98», el sistema sabía que se estaba haciendo referencia a 1998. El problema venía con el año 2000 porque, para los ordenadores, el «00» se referiría a 1900. Es decir, que todos los sistemas informáticos viajarían cien años al pasado.

Se pensaba que al ocurrir esto, todas las compañías, gobiernos y telecomunicaciones colapsarían por completo y, por ende, la humanidad regresaría a algo similar a la edad media, en donde no habría manera de comunicarnos y tendríamos que empezar de cero.

¿Por qué se produjo el problema?

En las décadas de 1950 y 1960 la norma en los ordenadores era representar los años con dos dígitos. La razón era ahorrar espacio. Las primeras computadoras tenían poca capacidad de almacenamiento y solo una fracción de la memoria RAM de las máquinas modernas. Los programas tenían que ser lo más compactos y eficientes posible porque se leían de tarjetas perforadas, que tenían un ancho finito (generalmente, 80 columnas). No se podía escribir más allá del final de la línea en una tarjeta perforada.

A pesar de su tamaño, los primeros ordenadores tenían poca capacidad. (Foto: IBM)

Ante esta limitación, cualquier medida que permitiera ahorrar espacio era puesta en práctica inmediatamente. Una de las más fáciles fue consignar los años con dos dígitos en lugar de con cuatro. El 77 se entendía como 1977.

Hubo un momento en que las capacidades del hardware mejoraron, había procesadores más rápidos, más memoria RAM y las terminales de computadora reemplazaron las tarjetas perforadas y las cintas. Se utilizaron medios magnéticos, como discos duros, para almacenar datos y programas. No obstante, aunque la tecnología avanzaba y en los departamentos que usaban grandes ordenadores se renovó o reemplazó el software, el formato de datos permaneció sin cambios. El software continuó usando años de dos dígitos. A medida que se acumulaban más datos, el problema se agravaba.

El cuerpo de datos era enorme en algunos casos. Por eso, recortar de cuatro dígitos a dos los años era una forma rápida de reducir a la mitad su necesidad de almacenamiento. Además, cuantas más fechas se tuviera que manejar, mayor sería el beneficio. Sin embargo, según fue llegando al final el siglo XX muchos informáticos, responsables de compañías y gobiernos fueron cayendo en la cuenta de un problema muy grave que estaba a la vuelta de la esquina y cuyas consecuencias podrían ser catastróficas.

Los ordenadores estaban programados para guardar el año de la fecha con dos dígitos. (Foto: Profesional Review)

El problema de los dos dígitos en el año

Si los equipos informáticos solo usaban dos dígitos para valores de año, no podían diferenciar entre fechas de diferentes siglos. El software fue confeccionado para tratar todas las fechas como si fueran del siglo XX. De este modo, al dar las 12 de la noche del 31 de diciembre de 1999, todos los ordenadores (y todos los dispositivos con un microprocesador y software integrado) que almacenaban y procesaban fechas como dos dígitos enfrentarían este problema. Quizás el software aceptaría la fecha incorrecta y continuaría, o tal vez arrojaría un error y seguiría funcionando, o directamente dejaría de trabajar.

Esto no solo se aplicaba a mainframes, minicomputadoras, redes y escritorios. Los microprocesadores estaban funcionando en aviones, fábricas, centrales eléctricas, sistemas de control de misiles y satélites de comunicación. Prácticamente todo lo que era automatizado, electrónico o configurable tenía algún código. La escala del problema era monumental.

En busca de una solución

El temor a que la humanidad retrocediera varios siglos como consecuencia del colapso de los sistemas informáticos provocó el miedo en muchas capas de la población.

Esto se vio alimentado por el tratamiento dado al problema por algunos medios de comunicación, que se hicieron eco de la necesidad de actualizar los ordenadores para evitar poco menos que un apocalipsis digital. Ciertos movimientos neoludistas (que niegan la capacidad de cualquier nueva tecnología de poder resolver los problemas) y/o religiosos anunciaron el fin de la civilización, combinando los delirios habituales cuando se aproxima un final de siglo o de milenio con este efecto Y2K.

Guía de supervivencia para el Y2K bug. (Foto: Amazon)

Según se iba acercando la fecha del 31 de diciembre de 1999, muchas personas en todo en mundo comenzaron a hacer acopio de alimentos, y en Estados Unidos y otros países de armas, como si se acercara un huracán. La histeria se apoderó de muchas personas. Algunas empresas comenzaron a comercializar con bastante éxito Kits de Supervivencia al Y2K, que contenían comida enlatada de todo tipo y artículos de primera necesidad que se pudiera requerir cuando la sociedad comenzara a colapsar.

Aunque las alertas sobre este peligro empezaron a aparecer de manera más recurrente en los medios de comunicación en 1998, muchos técnicos llevaban años trabajando para atajar el problema.

En 1995, la Bolsa de Valores de Nueva York había completado un proyecto de siete años para corregir todos sus sistemas, para lo que invirtieron 30 millones de dólares, pero la mayoría de las organizaciones apenas habían comenzado a trabajar en este aspecto: una encuesta del Reino Unido en 1995 desveló que solo el 15% de los gerentes sénior estaban al tanto del problema. Ante esta situación, los auditores comenzaron a decirles a las empresas que no aprobarían las auditorías a menos que esas compañías tuvieran una garantía creíble de que sobrevivirían más allá de enero de 2000.

La Bolsa de Nueva York invirtió 30 millones de dólares para prevenir el Efecto 2000. (Foto: NYSE)

En diciembre de 1988 se celebró la primera reunión mundial de coordinadores nacionales de Y2K de Naciones Unidas. Aunque cada país gestionó como supo o pudo este Efecto Y2K, a nivel internacional se creó lo que se conoció como International Y2K Cooperation Center, una manera de organizar a los responsables del asunto en cada uno de los 120 países que formaron parte.

Desde diferentes administraciones o empresas se fue trabajando en la resolución del problema, pero los trabajos no se desarrollaron en muchas ocasiones con la diligencia que hubiera sido deseable.

En mayo de 1998, la CIA publicó un informe en el que aseguraba que la mayoría de los Gobiernos del mundo estaban “mal preparados y poco preocupados” para los efectos que podía tener el denominado efecto del año 2000 en los ordenadores. El servicio de espionaje estadounidense afirmaba que había contactado con muchos Gobiernos a fin de advertirles de los riesgos del efecto 2000, pero que encontró escaso eco a sus preocupaciones.

“Estamos muy preocupados por los posibles cortes en los sistemas de electricidad, telecomunicaciones y banca en todo el mundo, que, en el caso de países y regiones con fuertes tensiones políticas, tendrían efectos desastrosos”, decía el informe de la CIA. “Muchos gobiernos”, aseguraba el documento, “están muy poco preparados para las muy duras circunstancias que podrían tener que afrontar”. Según la CIA, solo Canadá, el Reino Unido y Australia estaban intentando adelantarse a la catástrofe, y aun así llevaban seis meses de retraso en relación con Estados Unidos. El resto de Europa occidental está entre seis y nueve meses por detrás.

Sede de la CIA. (Foto: Panda Security)

El caso europeo era especialmente apremiante. A la llegada del año 2000 había que añadir que el 1 de enero de 1999 entraba en funcionamiento el euro en 11 países para ciertos intercambios (al público no llegaría hasta 2002). Dado que la nueva moneda reintroducía el uso de céntimos, los ordenadores tenían que estar preparados para el cambio.

En el Discurso del Estado de la Unión de 1999 del presidente de Estados Unidos, Bill Clinton, dijo: “Necesitamos que todos los gobiernos estatales y locales, todas las empresas, grandes y pequeñas, trabajen con nosotros para asegurarnos de que el error informático Y2K sea recordado como el último dolor de cabeza del siglo XX, no como la primera crisis del siglo XXI”.

Clinton ya había exhortado al Gobierno a mediados de 1998 a «poner nuestra propia casa en orden». Las grandes empresas, impulsadas por sus propias pruebas, respondieron de la misma manera, acumulando un gasto estimado de 100.000 millones solo en Estados Unidos. Sus preparativos abarcaron una amplia coordinación a nivel nacional y local, así como a escala mundial, con otras naciones digitalmente dependientes que examinaron sus propios sistemas.

Medidas en Europa

Desde la Unión Europea se pusieron en marcha diversas iniciativas para prevenir los efectos del Y2K bug. Lo que ocurre es que la Comisión Europea hizo un análisis de la situación que pudo hacer dudar a muchas personas sobre la eficacia de lo que se estaba haciendo. En un comunicado titulado Análisis de la Comisión sobre el problema del efecto 2000, se hacía un repaso de las conclusiones de un estudio encargado por la propia Comisión: Y2K bug and the consumer (El efecto 2000 y el consumidor). Sus afirmaciones eran demoledoras y muy poco tranquilizadoras para una población cada vez más asustada.

Sede de la Comisión Europea. (Foto: TJUE)

El informe afirmaba que “las dificultades de las empresas tendrán repercusiones en sus consumidores, quienes serán, a todas luces, las víctimas de los contratiempos que surjan durante la transición al año 2000″.

Según este análisis, “el alcance del problema es tan grande que cualquier corrección sólo podría ser parcial, pues el mismo continuaría enclavado en el hardware, los programas y microprocesadores, con efectos difíciles de predecir. Los consumidores serán vulnerables de manera directa a dichos errores potenciales y, por consiguiente, deberían tomar precauciones para minimizar los daños”.

En este contexto, la Comisión aconsejaba a los consumidores europeos que estuvieran informados “sobre las protecciones legales existentes, incluyendo las garantías comerciales, certificados y etiquetas. Las herramientas jurídicas que ofrecen la legislación de protección al consumidor, las regulaciones sobre las ventas y las normativas ordinarias relativas a la disponibilidad varían de manera significativa entre los diferentes Estados miembros, aunque algunas directivas europeas han tratado de alcanzar cierto grado de armonización”.

Para rematar este mensaje de inquietante contenido, el comunicado subrayaba que los riesgos son mayores en los sectores alimentario y médico, “pues las consecuencias podrían resultar fatales”.

El presidente del Gobierno, José María Aznar, el 1/1/2000 en la Oficina de transición para el Efecto 2000. (Foto: EFE)

No obstante, a pesar de los mensajes en ocasiones semi apocalípticos, lo cierto es que hubo un momento en el que empresas privadas y gobiernos apretaron el acelerador y realizaron importantes inversiones y una apuesta clara por prepararse para lo que pudiera llegar.

Por ejemplo, en España, el Gobierno puso en marcha en 1998 la Coordinadora General del Efecto 2000, una subdelegación del Ministerio de Industria encargada de adaptar los softwares informáticos de la administración pública e incluso de algunas empresas privadas. El Estado español se gastó 420 millones de euros en actualizaciones; otros, como Estados Unidos, más de 93.000 millones. A nivel mundial, el gasto total alcanzó los 214.634 millones de euros de la época.

Llegó el gran día y no se acabó el mundo

Ante la llegada del 1 de enero de 2000, el mundo contuvo la respiración. En aeropuertos, bancos, aseguradoras, infraestructuras estratégicas o grandes compañías miles de personas recibieron el nuevo año en estado de máxima alerta ante la previsión de que ocurriera lo peor. Sin embargo, los peores augurios no se cumplieron, lo que no quiere decir que hubiera problemas.

Se registraron algunas anécdotas, como la de un videoclub de Nueva York facturó más de 90.000 dólares a uno de sus clientes por haber alquilado una película durante más de un siglo; el primer bebé nacido en el nuevo milenio en Dinamarca tenía 100 años al nacer, según el sistema informático del hospital. En Suecia, 100.000 personas no pudieron acceder a sus cuentas bancarias a través de Internet porque no actualizaron el software de su navegador, mientras que en Italia y España los ordenadores de varios juzgados emitieron citaciones para el año 1900.

Planta nuclear de Onagawa, en Japón. (Foto: Hmn.Wiki)

Al margen de estos hechos, se registraron problemas más serios. Por ejemplo, en Japón, que posiblemente fue el país más transparente a la hora de reportar sobre problemas relacionados con el Y2K bug, se informó de que a medianoche el primero de enero de 2000 en la planta nuclear de Onagawa sonó la alarma entre las 00:02 de 1 de enero de 2000 y las 00:12. Durante esos diez minutos se dejaron de recibir datos relacionados con las estaciones de monitorización, la radiación en el agua, la temperatura del agua y los datos relacionados con la meteorología. En la central de Ishikawa se produjo un problema similar de ausencia de datos, aunque en ese caso no sonó ninguna alarma.

La central nuclear de Fukushima, que se haría famosa tras el tsunami de 2011, también padeció el Efecto 2000. En concreto, a las 8:58 de la mañana del primer día de 2000, el sistema que muestra la posición de las barras de control en el núcleo del reactor falló, dejando a los operadores sin la capacidad de poder calibrar las posiciones de las barras usando el sistema. El error se resolvió a las 11:15 del mismo día, unas horas después. Al parecer, el reloj de la computadora afectada se había puesto en la fecha 6 de febrero de 2036.

Por otra parte, los satélites espías estadounidenses fallaron y enviaron datos ilegibles durante tres días. El fallo no ocurrió debido al error Y2K en sí, sino a un parche que se suponía que lo solucionaría.

Los satélites espía estadounidenses fallaron durante tres días. (Foto: ICS)

Posiblemente, una de las consecuencias más graves relacionadas con el Efecto 2000 se vivió en Reino Unido, aunque el problema se conoció meses después, cuando un médico de Yorkshire notó un número inusual de bebés que nacían con síndrome de Down.

A más de 150 mujeres embarazadas se les dieron resultados erróneos en las pruebas porque el sistema informático que se utilizó en nueve hospitales, y que había funcionado perfectamente durante la década anterior, calculó incorrectamente la fecha de nacimiento de las mujeres a partir de enero de 2000.

Como consecuencia, madres con alto riesgo de tener hijos con síndrome de Down eran catalogadas como bajo riesgo. De ahí que los hospitales no valoraran realizar una prueba de amniocentesis que hubiera confirmado o descartado el síndrome.

En vista de que no se produjo la catástrofe que muchos vaticinaban, lo que había sido un motivo de gran preocupación se convirtió de repente en motivo de broma y sobre todo de críticas. No hubo que esperar muchos días desde el 1 de enero para oír las primeras afirmaciones de que todo había sido una exageración. Acusaban a las grandes empresas informáticas de haber hinchado un globo con un peligro inexistente para aumentar sus ventas y ganar mucho dinero.

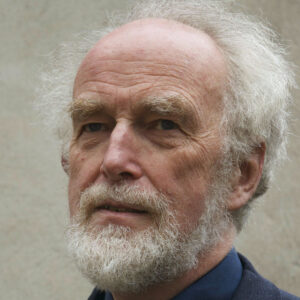

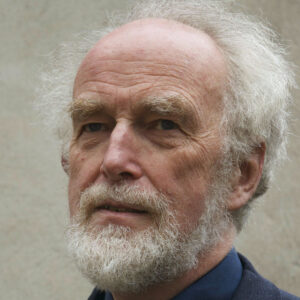

Esta es una afirmación que ha sido rebatida por muchos expertos y, sobre todo, por personas que durante años estuvieron trabajando para evitar problemas. Una de las voces que más se ha hecho oír ha sido la de Martyn Thomas, experto en ciberseguridad y profesor de Tecnología de la Información en Gresham College (Londres).

El profesor Martyn Thomas. (Foto: Gresham College)

Thomas asegura que “el error del milenio fue real y el esfuerzo coordinado internacionalmente fue un gran éxito. Se evitaron decenas de miles de fallos”. Aunque reconoce que algunos proveedores se aprovecharon y vendieron actualizaciones innecesarias a sus clientes”, destaca que “aquellos de nosotros que trabajamos días, noches y fines de semana para cumplir con la dura fecha límite de diciembre de 1999 nos enojamos cuando la gente ignorante piensa que, porque lo logramos, la amenaza no era grave”.

Martyn Thomas estuvo en la primera línea de trincheras en los trabajos para prevenir el Efecto 2000. Durante mediados de la década de 1990, fue director del equipo internacional de Deloitte Consulting encargado de los trabajos sobre el Y2K. A la hora de hablar de su trabajo destaca que “se encontraron fallos en los ordenadores que controlaban las fábricas y las plataformas petroleras en alta mar. El sistema de misiles antiaéreos Rapier del Reino Unido tuvo un error Y2K que habría impedido que disparara”.

“Casi en todas partes que buscamos encontramos ordenadores que procesaban mal las fechas y tenían que ser revisados: el 10% de las máquinas de tarjetas de crédito Visa no podían manejar tarjetas que vencieron después de 1999, por lo que Visa pidió a los bancos miembros que dejaran de emitir tarjetas con fechas de vencimiento 00”, recuerda Thomas, quien subraya que “para la mayoría de las empresas, el trabajo necesario para encontrar y reparar todos los sistemas importantes fue, con mucho, el proyecto de tecnología de la información más grande que jamás habían emprendido”.