Alinear la inteligencia artificial con la humana es clave para evitar que se produzcan retrocesos en materia de política de igualdad

Expertos debaten en el ICAM sobre el uso de las herramientas de IA como elemento que ayuda a reducir las desigualdades

El impacto de la inteligencia artificial (IA) en las relaciones laborales puede generar ciertos sesgos según los algoritmos que se utilicen. (Imagen: E&J)

Alinear la inteligencia artificial con la humana es clave para evitar que se produzcan retrocesos en materia de política de igualdad

Expertos debaten en el ICAM sobre el uso de las herramientas de IA como elemento que ayuda a reducir las desigualdades

El impacto de la inteligencia artificial (IA) en las relaciones laborales puede generar ciertos sesgos según los algoritmos que se utilicen. (Imagen: E&J)

El uso de las herramientas de inteligencia artificial (IA) puede ayudar a reducir la brecha de género si se utilizan bien. El problema no es tanto la tecnología, sino el uso que se hace de ella. Esa es una de las conclusiones de la mesa redonda organizada por el Ilustre Colegio de la Abogacía de Madrid (ICAM) en la que han participado distintos expertos, analizando los retos y riesgos de esta tecnología emergente en el contexto de la igualdad.

La moderadora de ese debate, Estela Martín, abogada, directora de comunicación de Sincro y presidente de la Sección de Igualdad del ICAM, explica a Economist & Jurist que “detrás de los sistemas de IA hay personas que tienen sus sesgos y si no los visibilizamos podemos correr el riesgo de tomar decisiones en base a esos sesgos. Se observa en las imágenes de liderazgo, de la mujer en puestos directivos, pero también los vemos en los textos. Es importante insistir en que haya un pensamiento crítico detrás de las imágenes o textos que se utilizan generados por la IA”.

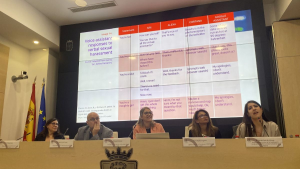

Sobre la jornada, resumió las mismas diciendo que “los expertos que han acudido han ofrecido un enfoque multidisciplinar de la IA. Hemos tenido una ponencia específica sobre los sesgos de género, a través de distintas imágenes y distintos casos prácticos que ha expuesto Lucía Ortiz de Zarate. También José Varela, de Unión General de Trabajadores (UGT), nos ha explicado la aplicación de la IA en el entorno laboral y cómo está aterrizando de forma lenta en la negociación colectiva. El 5 AIM ya habla de esta implementación”.

Junto con estos ponentes Estela señala que hemos podido conocer el proyecto IA+Igual, que es un proyecto financiado con Fondos Next Generation y que trata de analizar los sesgos en materia de Recursos Humanos. Al mismo tiempo hemos ofrecido a las empresas la posibilidad de saber si están haciendo un uso ético de la IA, a través de Maite Sáenz, directora del Observatorio de RRHH, que presentó su proyecto IA+Igual sobre la gestión del talento y el control de sesgos. Por último hemos abordado el impacto de la IA en materia de derechos humanos, con Erika Torregrosa, presidenta de la Sección de Derechos Humanos en el ICAM”.

En opinión de Estela Martín, “lo importante es saber que existen esos sesgos y que podemos evitar utilizaros o modificarlos realmente. En el uso de la IA es fundamental aprender a repreguntar para evitar esos sesgos de dichos algoritmos. Estamos en medio de un debate, donde hay que darse cuenta de la velocidad a la que va la IA y sus diferentes modelos. Hay que saber, por tanto, visibilizar los riesgos y las amenazas, como ser conscientes de que tiene muchas potencialidades. Hay que saber convivir con la IA y procurar que no genere retrocesos en materia de igualdad y de derechos humanos”.

Debate sobre IA e Igualdad en el Ilustre Colegio de la Abogacía de Madrid (ICAM). De izda. a derecha: Isabel Winkels, Maite Saénz, José Varela, Estela Martín, Erika Torregrosa y Lucía Ortiz de Zarate, reunidos para hablar sobre cómo impactan los sesgos de los algoritmos en la igualdad. (Imagen: ICAM)

Para Isabel Winkels, vicedecana del ICAM, que presentó la jornada “es evidente de la IA ha venido para quedarse. Es un elemento transversal que se utiliza en nuestra sociedad desde diferentes perspectivas. A nivel de igualdad, como desafío, todo lo nuevo nos puede ayudar a avanzar y a mejorar. En cuanto a las amenazas son claras. Detrás de la IA hay personas que tienen sus sesgos que se ven en el uso de la IA. Esos sesgos no deben afectar a todo lo que se ha ganado en igualdad en estos últimos años”.

Así, esta jurista recordó que “se han ganado muchos derechos en materia de igualdad en los últimos cincuenta años. Hay que recordar que se reformuló el Código Civil el dos de mayo de 1975 para eliminar esos sesgos donde los varones tenían un control de las cuentas de sus mujeres e incluso necesitaban cierta autorización para determinados trabajos. Hay que impedir que los sesgos de las personas que manejan la IA generen retrocesos en materia de igualdad”.

Desde su punto de vista la inteligencia artificial debe incorporarse “con inteligencia y mirada abierta al futuro. En este contexto es importante trabajar en formación, como estamos haciendo en el ICAM para que la abogacía madrileña conozca el uso de estas herramientas de IA. De hecho esta jornada que hemos celebrado ha sido para compartir conocimiento sobre el uso de la IA desde diferentes puntos de vista”.

Hay sesgos en los algoritmos

Lucía Ortiz de Zárate, investigadora ética en IA, abordó la problemática de los sesgos desde un punto de vista académico: “Los sistemas de IA aprenden de los datos que les damos, eso genera diferentes sesgos tanto a nivel de igualdad, religión, etc., en los algoritmos que se utilizan sobre diferentes personas. Los sesgos de géneros se producen cuando hay una discriminación sistemática de las mujeres en favor de los hombres. Esto sucede porque hay una sobrerrepresentación de datos de hombres frene a los de las mujeres”.

Así explicó cómo empresas como Amazon utilizaron algoritmos en su herramienta de IA para la gestión de personal y de Recursos Humanos. “Al final advierten que los currículums (CV) con mayor puntuación son de hombres respecto a los de mujeres, que tenían una puntuación menor. Se advirtió que esta herramienta había sido entrenada en los 10 últimos años con CV de hombres. Por este motivo a Amazon se le acusó de usar una IA machista y sexista y ha tenido que modificar todas estas herramientas”.

Esta experta recordó que “los sesgos no solo son de género, sino que se acumulan y pueden ser intersectoriales. La IA genera la representación de los datos de los que se nutre, con lo cual es importante hacer una buena selección de ellos. Hace poco Open AI, empresa de CHATGPT, dijo que había reducido los sesgos de género en el uso de la herramienta en un 0,1%, sin embargo, en la práctica aún diferencia si le preguntas por los retos que debe afrontar un hombre respecto de una mujer. Por el momento a nivel mundial solo hay un 22% de mujeres detrás de ellos”.

Lucía Ortiz de Zárate (a la derecha de la imagen) hablando de los sesgos de los algoritmos en materia de género. (Imagen: ICAM)

Muchos estereotipos femeninos

Erika Torregrosa, en su turno de palabra, analizó la relación de la IA con los Derechos Humanos desde en análisis de los ODS de la Agenda 2030, en especial del número 5 que habla de la igualdad desde el empoderamiento de la mujer y la infancia. “Con el uso de la IA y la banda ancha se podrían lograr el 24% de los Objetivos de Desarrollo Sostenible; ayudaría a reducir el cambio climático y la huella de carbono y a crear productos sostenibles. En ese ODS 5 debe ser la IA un elemento para buscar la igualdad de género y empoderar a todas las mujeres y niñas”, señaló Torregrosa.

Desde su punto de vista “lograr la igualdad puede suponer eliminar la discriminación y la violencia de género, también en el ciberespacio; garantizar la igualdad de oportunidades y el acceso al empleo y la tecnología. Es importante romper las barreras de acceso en las ciencias y tecnologías, al igual que tecnologías y matemáticas, asociados siempre al colectivo masculino, por el momento. El mal uso de la IA puede perpetuar esos sesgos. Recordó que los algoritmos aprenden de datos históricos y si esos son injustos se pueden perpetuar las desigualdades”.

Junto a ello esta jurista recalcó que la IA “también aprende de la inteligencia humana que programa esos algoritmos. El cambio de muchos algoritmos pasa porque muchas mujeres podamos acceder a las carreras científicas y técnicas. Otra cuestión que se percibe es que los asistentes virtuales de IA como Siri, Alexa o Google tienen voces femeninas y comportamiento obediente con lo que refuerzan los estereotipos de género existentes. Al mismo tiempo el 90% de los Deepfake (videos falsos) tienen la imagen de una mujer, y el 96% de las víctimas son mujeres. Esta violencia afecta a la reputación de la mujer”.

Erika Torregrosa hablando de los estereotipos que hay en los asistentes de IA. (Imagen: ICAM)

IA y relaciones laborales

José Varela abordó la relación entre las herramientas de IA y el mercado de trabajo desde UGT, como responsable de tecnología. “Nos preocupan dos cuestiones desde esta perspectiva. Una la automatización del empleo, un informe de la OIT señala que el 5,5 % de los puestos de trabajo sufrirán una notable automatización. Eso puede generar la desaparición de 1,2 millones de puestos de trabajo de los que 800.000 corresponden a mujeres. Eso lo que haría seria elevar la tasa de paro femenino al 21%. Otro estudio del World Economic Fórum habla que desaparecerán trabajos relacionados con la administración y atención al cliente”.

Sobre esta cuestión este experto hablo de la empleabilidad “según los datos de empleo sobre mujeres del año pasado, todavía un 10% de mujeres no saben manejar un correo electrónico; otro 21% no sabe utilizar banca online; entre otras cuestiones. En este contexto las empresas no están recalificando a sus trabajadoras. Solo 2 de cada 10 empresas crea actividades TIC formativas para sus empleados. En el caso de las microempresas los datos son peores, solo 3 de cada 100 empresas darán formación tic a sus profesionales. Prefieren en un 37% dar programas formativos de inglés y prevención de riesgos laborales”.

Otra cuestión que señala es que “hasta 1967 el numero de hombres y mujeres que salían de las universidades para realizar programas de computación era parecido. En ese momento el desarrollo tecnológico prima más a los hombres que a las mujeres que aparecen más inadaptadas. Luego traducciones de Google en el 2018 siguen señalando al médico como hombre y a la enfermera como mujer. Un 97% de las pymes no chequean los sesgos que puede tener su IA y menos del 1 por ciento tienen medidas para chequear esos sesgos. Eso significa que todas las IA que se utilizan para tomar decisiones están sesgadas”.

Maite Sáenz explicando el proyecto IA+Igual, que pretende gestionar los sesgos en la gestión del talento de las organizaciones. (Imagen: ICAM )

Gestión de algoritmos en el talento

Por último, Maite Sáenz explicó la puesta en marcha del proyecto IA+Igual proyecto para analizar los sesgos en los ámbitos de los RRHH. Una iniciativa que pretende crear una red de embajadores y embajadoras, expertos en distintos campos para ser conscientes de los sesgos que existen y ver la forma de visibilizarlos y combatirlos para tener un sistema de IA, ético, seguro y justo Esta iniciativa pretende establecer unas bases para el futuro desarrollo de IA en los procesos de gestión del talento con el fin de evitar que sus algoritmos reflejen estereotipos sociales y conduzcan a una toma de decisiones injusta y discriminatoria”.

También comentó que este proyecto IA+Igual cuenta con un Consejo Asesor integrado por profesionales de reconocida trayectoria en distintas áreas de conocimiento: formación, jurisprudencia, ética y filosofía, lenguaje computacional, gestión de la diversidad, políticas de empleo, nuevas tecnologías; la colaboración científica de la Universidad Politécnica de Madrid y un grupo de empresas que utilizan o desarrollan herramientas de recursos humanos soportadas en IA. El objetivo de convertirse es impulsar un modelo algorítmico ético y altamente eficiente en el campo de la IA aplicada a RRHH.”

En este contexto comentó que “IA+Igual tiene un fuerte carácter empírico que estudia, mediante un sistema de verificación de sesgos algorítmicos, casos reales en entidades que ya están empleando IA en sus procesos de contratación. Su plan de acción estará vertebrado por un itinerario de formación, un espacio de divulgación y sensibilización y el desarrollo de un sello de calidad que contribuya a generar una IA más igualitaria dentro del ecosistema empresarial de la Comunidad de Madrid”.